- 多角的データ分析による収益影響要因の特定

プロジェクトの第一段階として、人気アーケードゲームに関連する多様なデータソースを統合しました。

統合されたデータには以下のようなものが含まれます:

・店舗カルテデータ: 各店舗の基本情報や設備に関するデータ

・メダル集計データ: メダルの使用状況や売上に関するデータ

・サーバーデータ: ゲームのプレイ状況やスコアなどのデータ

・LINE登録者数: 公式LINEアカウントの登録者数推移

・家庭用ゲーム機販売数: 家庭用ゲーム機版の販売数データ

・YouTubeデータ: 関連動画の視聴回数や反応などのデータ

・プロモーション実施履歴: 各種プロモーション施策の実施時期や内容これらの多様なデータを一元化することで、多角的な視点からの分析が可能となりました。

データの統合後、Looker Studioを用いて探索的データ分析を実施しました。この過程で、BET数と関係が見られる項目として、以下の要因が特定されました:

1.店舗特性

・売上高: 店舗全体の売上げとBET数の関係

・営業面積: 店舗の広さとBET数の関係

・メダル台数: 設置されているメダルゲーム機の数とBET数の関係

2.顧客属性

・メダルメイン顧客比率: メダルゲームを主目的とする顧客の割合とBET数の関係

・幼稚園児以下家族割合: 小さな子供連れの家族の割合とBET数の関係

3.ゲーム機器

・ビデオゲーム台数: 設置されているビデオゲーム機の数とBET数の関係

・カードゲーム台数: 設置されているカードゲーム機の数とBET数の関係

4.季節性

・年末年始などの特定時期: 季節や特定イベント時期とBET数の関係

これらの要因を特定したことで、次のステップである影響度の定量化に進むことができました。

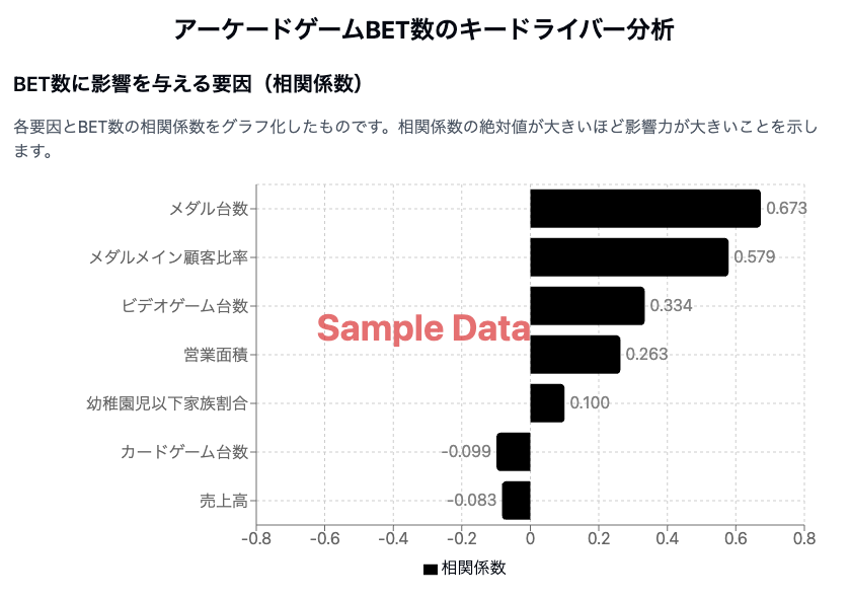

- 相関分析によるキードライバーの定量化と影響度評価

特定された要因について、BET数との相関分析を実施し、各要因の影響度を定量化しました。

分析の結果、以下のキードライバーが明らかになりました:

1.メダル台数BET数と最も強い正の相関を示す要因であることが判明しました。これは、メダルゲーム機の設置数がBET数と関係があることを示しています。

2.営業面積2番目に強い正の相関を示しました。広い店舗ほどBET数が多い傾向が確認されましたが、これは単に面積が広いだけでなく、快適なゲーム環境の提供がBET数増加につながっている可能性も示唆しています。

3.メダルメイン顧客比率顧客属性の中で最も重要な要因であることが分かりました。メダルゲームを主目的とする顧客の割合が高い店舗ほど、BET数が多い傾向が見られました。

4.年末年始の時期季節性の中で最も顕著な影響を持つことが確認されました。この時期にBET数が大きく増加する傾向が見られ、季節性を考慮したプロモーション戦略の重要性が浮き彫りになりました。

また、予想に反して、LINE登録者数や家庭用ゲーム機販売数との直接的な相関は低いことも判明しました。これは、デジタルマーケティング施策やクロスプラットフォーム展開が必ずしも直接的なBET数の増加につながっていない可能性を示唆しています。

プロモーション施策の効果については、テレビCMと年末年始の季節要因が重なっていたため、単独での効果測定は困難でした。しかし、この時期のBET数増加が顕著であることが確認され、効果的なタイミングでのプロモーション実施の重要性が示唆されました。

これらの分析結果により、人気アーケードゲーム機のBET数の構造をデータドリブンで理解し、より効果的な経営戦略の立案が可能となりました。

具体的には以下のような示唆が得られました:

1.メダル台数の最適化各店舗の特性に応じた最適なメダル台数の設定が重要であること。

2.店舗レイアウトの改善営業面積とBET数の関係から、効率的な店舗レイアウトの重要性が示唆されたこと。

3.メダルゲームメイン顧客向けのサービス強化特定の顧客層に焦点を当てたサービス改善やプロモーションの重要性が明確になったこと。

4.季節性を考慮したプロモーション戦略年末年始などの特定時期に合わせた効果的なプロモーション施策の立案が重要であること。

5.デジタルマーケティング施策の再評価:LINE登録者数や家庭用ゲーム機販売数との相関が低かったことから、これらの施策の目的や効果測定方法の見直しが必要であること。

これらの知見を活用することで、大手ゲーム会社様は収益最大化に向けた戦略立案と実行が可能となり、今後のビジネス展開に大きく寄与することが期待されます。

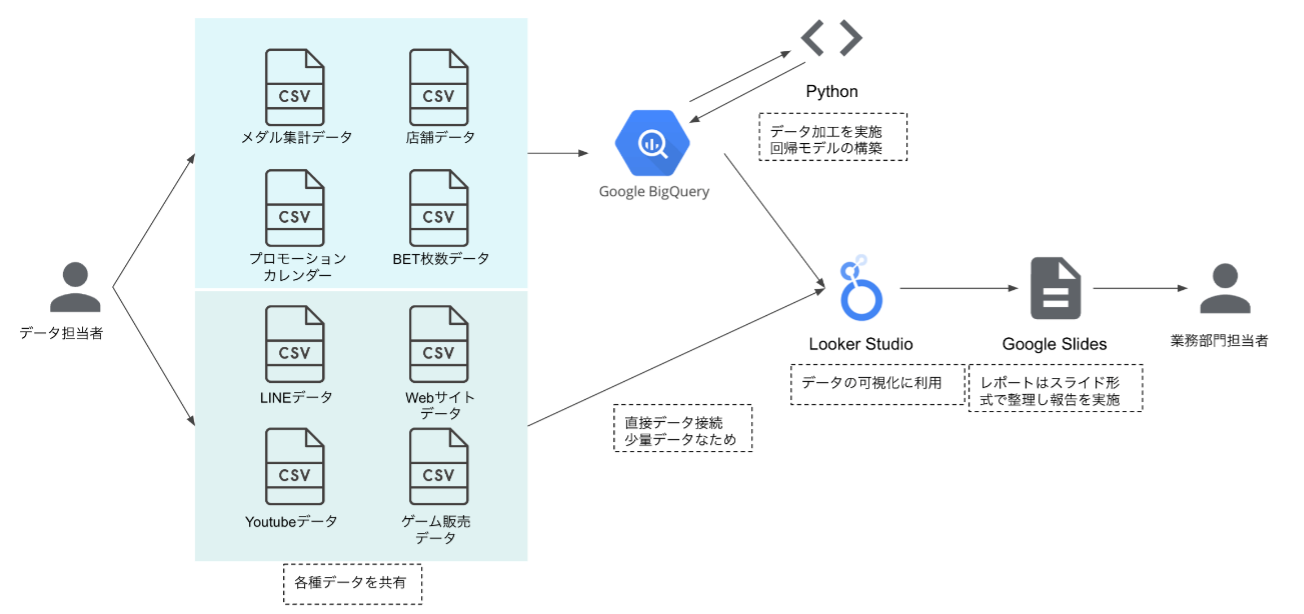

▼システム構築図

- 使用プロダクト

本プロジェクトでは、以下のプロダクトを使用しました:

1.Looker Studio:データの可視化で使用しました。多様なデータソースを一元化し、直感的なダッシュボードを作成することで、効率的なデータ分析を可能にしました。

2.Google BigQuery:データの統合と分析の高速化のために利用しました。

3.Python:データ処理と分析に使用しました。大量のデータを効率的に処理し、高度な統計分析を行うことができました。特に、scikit-learnライブラリを活用し、重回帰分析モデルの構築を行いました。

これらのツールを組み合わせることで、複雑なデータ分析を効率的に行い、示唆を導き出すことができました。